本記事の原文はであるNutanix Communityに投稿されているAHVのOpen vSwitchの基本に関する記事の翻訳です。

投稿されてから時間はたっていますが、AHVを構成する際にベースとなる構成の為、改めて紹介していきます。

原文を参照したい方はMaximum Performance from Acropolis Hypervisor and Open vSwitchご確認ください。

情報は原文の投稿時のままの情報ですので、現時点では投稿時の情報と製品とで差異が出ている場合があります。

当社のNutanix社製品についてはこちら。本ブログのNutanix関連記事のまとめページはこちら。

ネットワールドのNutanix関連情報は、ぜひ当社のポータルから取得ください。

(初回はID、パスワードの取得が必要です)

Nutanixではデータネットワークをストレージのバックプレーンとして利用し、次の事がお客様がAHVを利用する上でAHVがデータセンターネットワークに接続するための良い方法なのかを決められる事を目的としています。

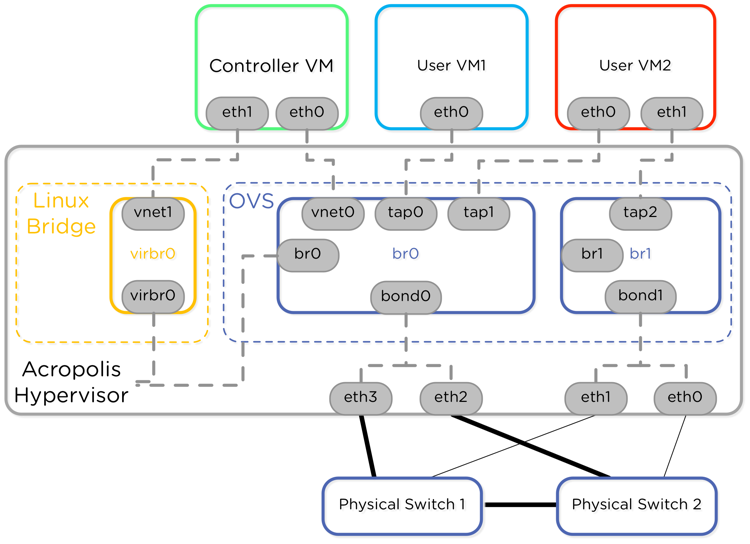

いくつかのバックグランドから始めましょう。AHVはOpen vSwitch(OVS)はCVM、HypervisorとゲストVM、物理ネットワークが接続されています。

OVS のサービスは各AHVノードで稼働し、OVSのサービスは自動的に起動します。

このブログはAHVの一部の内容であり、Open vSwitch BridgeとBondsの内容を包括しています。

来週のパートではロードバランス、VLANとAcropolisの管理ネットワークに触れていきますので、是非来週もご覧ください(できれば翻訳しようと考えてます)

OVS内の、bondのポートはAHVホストの物理インターフェイルにありデフォルトではbond0と名前がづけられbr0が作成されます。

(現在の最新のAOS 5.10ではボンド名はbr0-up , Bridge名はbr0となりますのでご注意ください)

ノードのイメージング(初期化)が完了したとは全てのインターフェスは一つのbondへ設定されます。これはFoundation Imagingプロセスの要件となります。

次のダイアグラムはイメージング直後の1ノードのネットワーク構成となります。

次にnu.schoolのVideo(youtube動画)でデフォルトの構成についてもっと多くの事を学ぶとことが出来ます。デフォルトの設定を変更するためのコマンドやacli,cli toolについてのいくつか参考になるものも見つけることが出来るでしょう

![Tech TopX: AHV Host Networking [Part01]](https://i.ytimg.com/vi/KLkRZlOWRhg/default.jpg?w=425&h=355&player=1)

YouTube: Tech TopX: AHV Host Networking [Part01]

大事なポイントはNutanixのCVMは10Gbアダプタに設定する事です(今では40Gbもあります)

これで最大のBandwidthと低いレイテンシーの実現をCVMへ提供するのです。それに加えてUser VMによって物理トラフィックを分けたいと思う事もあるかも知れません。

このネットワークを分離する事はセキュリティポリシー、仮想マシンのネットワーク(例えばルーティング、FireWall,ロードバランス)などによって必要になるかもしれません。

これはAHV OVS構成の推奨で1GbのNICを使った新しいブリッジの作成です。

推奨の構成は10Gと1Gのインターフェイスを別々のBondへ構成し、CVMとUserVM通信は常に最速のLinkを使います。

ここでは10G(eth2, eth3)はbond0(br0-up)へグループし、CVMとUser VM1 へ

1GのインターフェイスはBond1へグループしUser VM2で利用します。

bond0とbond1はそれぞれブリッジ (br0 , br1)へ追加します。

この構成ではCVMとUser VMは10Gbのインターフェイスを利用し ブリッジ br1はCVMとbr0にいるVMから物理的にネットワークを分ける必要がある仮想マシンの為に利用できるようになります。

Eth0 , Eth1はさらに別のアップリンクのスイッチへ接続して分離する事も出来ます。

2つの上位スイッチはそれぞれのbondのインターフェイスのペアが接続し、bondの中では一つのインターフェイスがアクティブとして動作します。これはデフォルトのActive-Backup モードを利用した際の動作です。

ロードバランスについては次週に記載します。

Nutanix Clusterの各ノードで次を実施し、各Acropolis hostでブリッジbr1を追加、ローカルのAcropolis Hypervisor へはCVMから192.168.5.1 に対して接続できます。

【

CVMへログインしブリッジ br1を作成】

nutanix@CVM$ ssh root@192.168.5.1 "ovs-vsctl add-br br1"

CVMからeth0 , eth1 をすべてのCVMのデフォルトのbr0から削除します。

これらのインターフェイスはeth2 , eth3をBridgeに残して削除されます。「10g」は全ての10g インターフェイスを指定する事になります。(もちろんeth2,eth3のようなインターフェイス指定も可能です)

【br0へ10Gのみを追加する場合]

nutanix@CVM$ manage_ovs --bridge_name br0 --bond_name bond0 --interfaces 10g update_uplinks

ー>現在のデフォルトの--bond_nameはbr0-upとなります

【br0へeth2,eth3のみを追加する場合]

nutanix@CVM$ manage_ovs --bridge_name br0 --bond_name bond0 --interfaces eth2,eth3 update_uplinks

ー>現在のデフォルトの--bond_nameはbr0-upとなります

eth0とeth1をbr1へ追加する方法、「1g」のインターフェイス指定をすることも可能です

【br0へ1Gのを追加する場合]

nutanix@CVM$ manage_ovs --bridge_name br1 --bond_name bond1 --interfaces 1g update_uplinks

今や、1gbのインターフェイスが存在するbr1が存在しています。

aCLIコマンでUser VM2の為のネットワークを作ることができます。

PrismのGUIからネットワークを確認する際にブリッジ名とネットワーク名は役に立つのでここは名前を解りやすくしましょう

[cvmからbri1へvlan 99を作成、登録するコマンド]

nutanix@cvm$ acli net.create br1_vlan99 vswitch_name=br1 vlan=99

これで一つのAHVとCVMが10Gを通して接続する事が出来るようになり、User VMは10G か1Gかに接続する事が出来るようになりした。上にのせているyoutubeも参考になるので、ご参照ください。

ここでさらに便利なコマンドをご紹介!

ブリッジの作成などは全てのCVMに対して実施する必要がありますが、Nutanix Cluster全体のCVMはAHVへコマンドを投げることも出来ます。

全てのCVMへCLIを実施するには allssh、全てのAHVでCLIを実施するにはhostsshです。

この辺りをうまく利用しAHVの管理性を高めてみてはいかがでしょうか

記事担当者 : SI技術本部 カッシー @Networld_NTNX