-

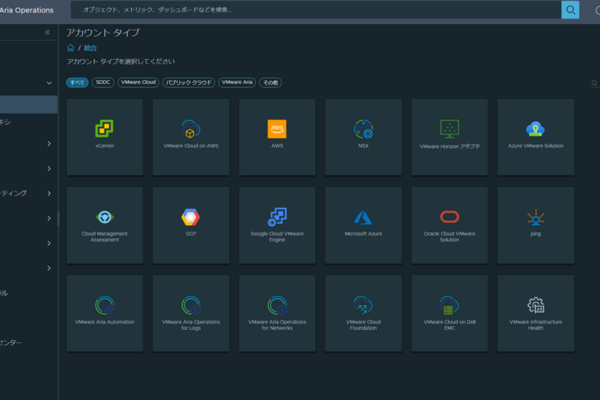

AWSと連携!Aria Operationsでクラウド監視体験!

皆様、こんにちは! VMware by Broadcom製品担当の殿貝です。 突然ですが、Aria Operations使ってますか? ライセンス体系の変更によって、Aria Operationsが標準で使えるエディションもあり、今まで使ってなかった…

AWSと連携!Aria Operationsでクラウド監視体験!

皆様、こんにちは! VMware by Broadcom製品担当の殿貝です。 突然ですが、Aria Operations使ってますか? ライセンス体系の変更によって、Aria Operationsが標準で使えるエディションもあり、今まで使ってなかった… -

【Dell Blog】新時代の幕開け!PowerScale OneFS 9.5でSupportAss…

皆様、こんにちは!ネットワールドのストレージ担当SEの多川です。 今回はスケールアウトNASの代名詞、PowerScaleのリモートサポートについてOneFS 9.5から新機能が実装されましたので紹介していきます。一言で言う…

【Dell Blog】新時代の幕開け!PowerScale OneFS 9.5でSupportAss…

皆様、こんにちは!ネットワールドのストレージ担当SEの多川です。 今回はスケールアウトNASの代名詞、PowerScaleのリモートサポートについてOneFS 9.5から新機能が実装されましたので紹介していきます。一言で言う… -

【Dell Blog】セキュリティを強化しよう!VxRail管理アカウントのパスワード変更方法まとめ…

皆様、こんにちは!ネットワールド ストレージ担当の三嶽です。 セキュリティ意識が高まっている昨今、皆様が日々運用されている中で、定期的なパスワード変更が推奨される場合も多いのではないかと思います。 日常…

【Dell Blog】セキュリティを強化しよう!VxRail管理アカウントのパスワード変更方法まとめ…

皆様、こんにちは!ネットワールド ストレージ担当の三嶽です。 セキュリティ意識が高まっている昨今、皆様が日々運用されている中で、定期的なパスワード変更が推奨される場合も多いのではないかと思います。 日常… -

GitとCI/CDに関する知識ゼロのSEが、GitLab Pagesを活用して静的Webサイトをカス…

皆様こんにちは。SEの小池と申します。 GitLabには GitLab Pages という機能があり、GitLabのリポジトリから静的Webサイトを直接公開できます。 SaaS版の場合、GitLab PagesではGitLabがデフォルトで用意してくれて…

GitとCI/CDに関する知識ゼロのSEが、GitLab Pagesを活用して静的Webサイトをカス…

皆様こんにちは。SEの小池と申します。 GitLabには GitLab Pages という機能があり、GitLabのリポジトリから静的Webサイトを直接公開できます。 SaaS版の場合、GitLab PagesではGitLabがデフォルトで用意してくれて… -

【Dell Blog】PowerScaleのSnapRevert検証とスナップショット機能のおさらい…

皆様、こんにちは!ネットワールド ストレージ担当の島田です。今回はPowerScaleのスナップショットからのリストア機能「SnapRevert」について紹介していこうと思います。 SnapshotIQ まずPowerScaleのスナップショ…

【Dell Blog】PowerScaleのSnapRevert検証とスナップショット機能のおさらい…

皆様、こんにちは!ネットワールド ストレージ担当の島田です。今回はPowerScaleのスナップショットからのリストア機能「SnapRevert」について紹介していこうと思います。 SnapshotIQ まずPowerScaleのスナップショ…

-

AWSと連携!Aria Operationsでクラウド監視体験!

皆様、こんにちは! VMware by Broadcom製品担当の殿貝です。 突然ですが、Aria Operations使ってますか? ライセンス体系の変更によって、Aria Operationsが標準で使えるエディションもあり、今まで使ってなかった…

AWSと連携!Aria Operationsでクラウド監視体験!

皆様、こんにちは! VMware by Broadcom製品担当の殿貝です。 突然ですが、Aria Operations使ってますか? ライセンス体系の変更によって、Aria Operationsが標準で使えるエディションもあり、今まで使ってなかった… -

【Dell Blog】新時代の幕開け!PowerScale OneFS 9.5でSupportAssistに対応して直接接続もできるように!設定方法も一挙に紹介しちゃいます♪

皆様、こんにちは!ネットワールドのストレージ担当SEの多川です。 今回はスケールアウトNASの代名詞、PowerScaleのリモートサポートについてOneFS 9.5から新機能が実装されましたので紹介していきます。一言で言う…

【Dell Blog】新時代の幕開け!PowerScale OneFS 9.5でSupportAssistに対応して直接接続もできるように!設定方法も一挙に紹介しちゃいます♪

皆様、こんにちは!ネットワールドのストレージ担当SEの多川です。 今回はスケールアウトNASの代名詞、PowerScaleのリモートサポートについてOneFS 9.5から新機能が実装されましたので紹介していきます。一言で言う… -

【Dell Blog】セキュリティを強化しよう!VxRail管理アカウントのパスワード変更方法まとめ!

皆様、こんにちは!ネットワールド ストレージ担当の三嶽です。 セキュリティ意識が高まっている昨今、皆様が日々運用されている中で、定期的なパスワード変更が推奨される場合も多いのではないかと思います。 日常…

【Dell Blog】セキュリティを強化しよう!VxRail管理アカウントのパスワード変更方法まとめ!

皆様、こんにちは!ネットワールド ストレージ担当の三嶽です。 セキュリティ意識が高まっている昨今、皆様が日々運用されている中で、定期的なパスワード変更が推奨される場合も多いのではないかと思います。 日常… -

GitとCI/CDに関する知識ゼロのSEが、GitLab Pagesを活用して静的Webサイトをカスタムドメインで公開する

皆様こんにちは。SEの小池と申します。 GitLabには GitLab Pages という機能があり、GitLabのリポジトリから静的Webサイトを直接公開できます。 SaaS版の場合、GitLab PagesではGitLabがデフォルトで用意してくれて…

GitとCI/CDに関する知識ゼロのSEが、GitLab Pagesを活用して静的Webサイトをカスタムドメインで公開する

皆様こんにちは。SEの小池と申します。 GitLabには GitLab Pages という機能があり、GitLabのリポジトリから静的Webサイトを直接公開できます。 SaaS版の場合、GitLab PagesではGitLabがデフォルトで用意してくれて… -

【Dell Blog】PowerScaleのSnapRevert検証とスナップショット機能のおさらい!

皆様、こんにちは!ネットワールド ストレージ担当の島田です。今回はPowerScaleのスナップショットからのリストア機能「SnapRevert」について紹介していこうと思います。 SnapshotIQ まずPowerScaleのスナップショ…

【Dell Blog】PowerScaleのSnapRevert検証とスナップショット機能のおさらい!

皆様、こんにちは!ネットワールド ストレージ担当の島田です。今回はPowerScaleのスナップショットからのリストア機能「SnapRevert」について紹介していこうと思います。 SnapshotIQ まずPowerScaleのスナップショ… -

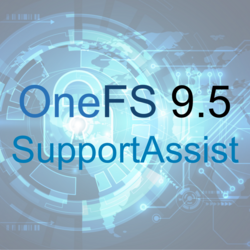

【Dell Blog】PowerStoreのドライブ増設って実は難しい?ハマるポイントと怖い仕様!

こんにちわ。ネットワールドストレージ担当の小野です。 今回はPowerStoreで実際にドライブ増設を行ってきた際のハマったポイントだったり、気を付けてもらいたいことなど紹介できればと思います。 まず、PowerStor…

【Dell Blog】PowerStoreのドライブ増設って実は難しい?ハマるポイントと怖い仕様!

こんにちわ。ネットワールドストレージ担当の小野です。 今回はPowerStoreで実際にドライブ増設を行ってきた際のハマったポイントだったり、気を付けてもらいたいことなど紹介できればと思います。 まず、PowerStor… -

【Dell Blog】PowerStoreのNVMe Over TCP環境構築: Smart Fabric Storage Softwareを活用してみよう

こんにちは! ネットワールドストレージ担当の武田です。 今回はSmart Fabric Storage Softwareという機能をつかって、PowerStoreでNVMe over TCP環境を構築してみたいと思います。 以後はSFSSと表記させていただき…

【Dell Blog】PowerStoreのNVMe Over TCP環境構築: Smart Fabric Storage Softwareを活用してみよう

こんにちは! ネットワールドストレージ担当の武田です。 今回はSmart Fabric Storage Softwareという機能をつかって、PowerStoreでNVMe over TCP環境を構築してみたいと思います。 以後はSFSSと表記させていただき… -

GitLab Duo Chatでテストコード自動生成を試してみませんか?

皆様こんにちは。SEの小池と申します。 皆様は普段の業務で生成AIを使っていらっしゃいますか? 文書の要約、キャッチフレーズの提案、音声からの文字お越しなど、様々な使い方で業務を効率化できる便利な生成AI…Gi…

GitLab Duo Chatでテストコード自動生成を試してみませんか?

皆様こんにちは。SEの小池と申します。 皆様は普段の業務で生成AIを使っていらっしゃいますか? 文書の要約、キャッチフレーズの提案、音声からの文字お越しなど、様々な使い方で業務を効率化できる便利な生成AI…Gi… -

【Dell Blog】InsightIQ5.0をデプロイしてみた

皆様こんにちは。ネットワールド ストレージ担当 後藤です。 InsightIQ使っていますか?PowerScaleのパフォーマンスやファイルシステム情報を取得するためのソフトウェアです。以前のブログでは、InsightIQ(以下、I…

【Dell Blog】InsightIQ5.0をデプロイしてみた

皆様こんにちは。ネットワールド ストレージ担当 後藤です。 InsightIQ使っていますか?PowerScaleのパフォーマンスやファイルシステム情報を取得するためのソフトウェアです。以前のブログでは、InsightIQ(以下、I… -

【Dell Blog】PowerShellでストレージを管理しよう

こんにちは、ネットワールドストレージ担当です。 今回はPowerShellを使用してストレージの操作を行う方法をご紹介します。 CLI操作はコマンド体系がストレージ毎に異なるため、それぞれのストレージ毎にコマンドを…

【Dell Blog】PowerShellでストレージを管理しよう

こんにちは、ネットワールドストレージ担当です。 今回はPowerShellを使用してストレージの操作を行う方法をご紹介します。 CLI操作はコマンド体系がストレージ毎に異なるため、それぞれのストレージ毎にコマンドを…