本ブログエントリーはPernixData社のテクノロジーエバンジェリストだったFrank Denneman氏のブログの翻訳版です。 Frank氏について、詳しくはこちらもご参照ください。

本記事の原文はPernixCloud Data: FVP Latency Compared To SAN Latencyで閲覧可能です。

ネットワールドのPernixDataに関する情報はこちら。本ブログのPernixDataの記事のまとめはこちら。

地球全体の仮想化データセンタをポータル化やESXiホストのCPUとメモリの構成についての考察そして、仮想マシンの密度(統合率)についての考察などの記事の中で、我々のPernixCloudの中のデータについて述べてきました。我々は世界中の仮想化データセンタのデータを多く集めることで、様々なアーキテクチャ、会社、運用を理解しようとしています。ですが、もちろん、我々は我々の製品のパフォーマンスについて理解するためにもこのデータを利用します。今回キーとなるメトリックは我々のFVPがどれだけワークロードのレイテンシを改善したか、という点です。Satyam氏はWoon Jung氏とSriram Sankaran氏にデータセットへとダイブし、どれだけのレイテンシが改善されたのかを明らかにするように命じました。以下はデータ取得時のSatyamによるコメントです:

データセット

Satyam :我々は日々91000ぐらいの仮想マシンを観察しています。仮想マシンのIOの特性は時刻や曜日によって変わり続けます。ドーナツチャートのそれぞれのセグメントごとの色はx-y%のレイテンシの改善がSANのレイテンシに対して見られた仮想マシンの割合を表しています。例えば、ドーナツチャートの左上の内側の(濃い)ブルーのセグメントはWrite-Thoroughに設定した仮想マシンの全体うち5%は0~19%のレイテンシの改善がFVPによって見られたということです。

以下の記事を読んで、FVPとWriteポリシーについて理解しておいてください:

我々は1382の仮想マシンの数年分のデータについて収集しました。データの表示は標準的に、一時間あたりでどれだけか、という値にしてあります。これはEC-2などのクラウドと比較しやすいようにするためです。

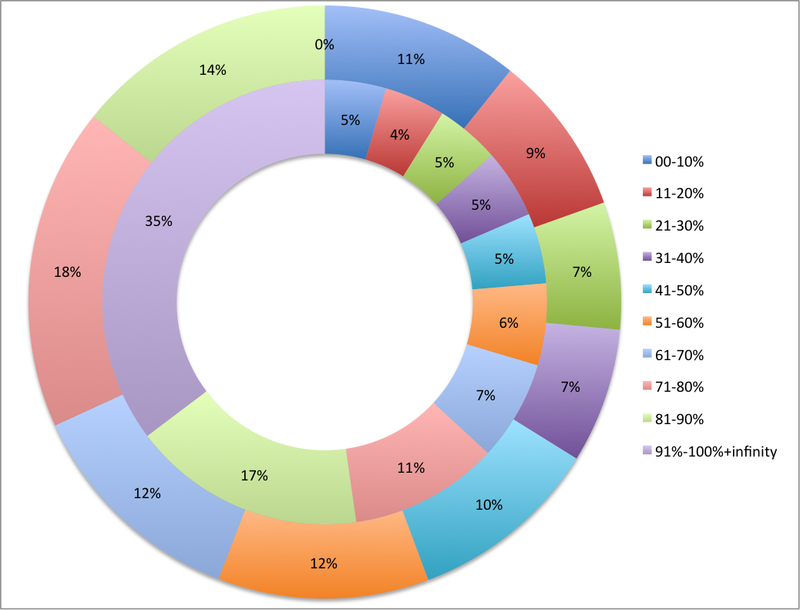

VMFS上のWrite Throughの仮想マシンのレイテンシの改善 ー Read(内側)とWrite(外側)

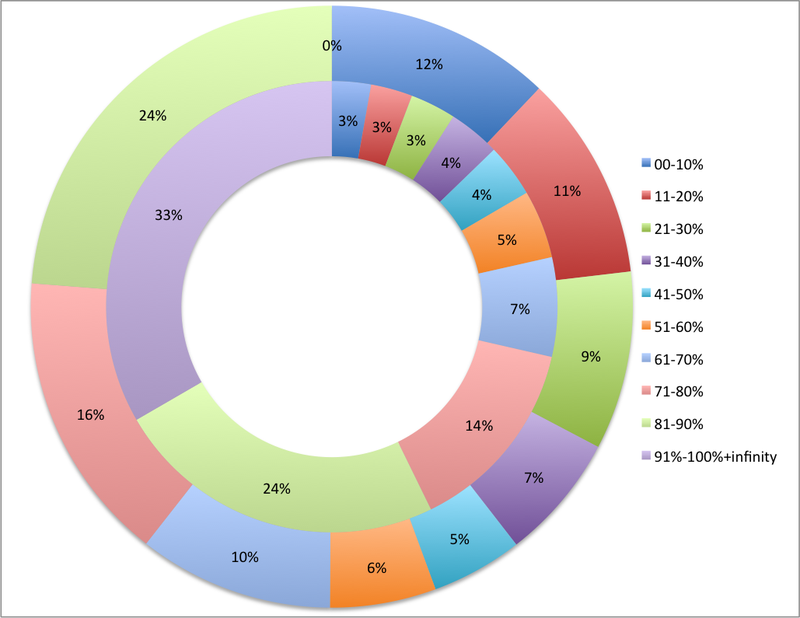

NFS上のWrite Throughの仮想マシンのレイテンシの改善 ー Read(内側)とWrite(外側)

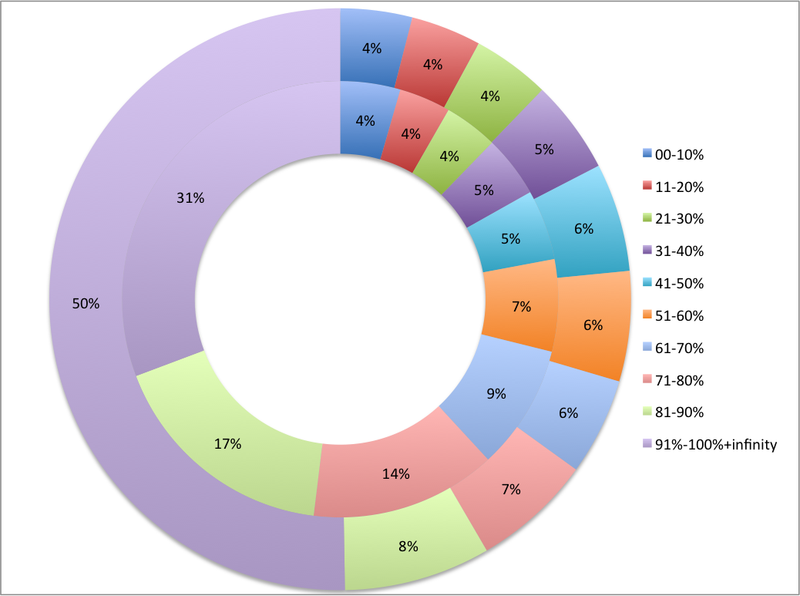

VMFS上のWrite Backの仮想マシンのレイテンシの改善 ー Read(内側)とWrite(外側)

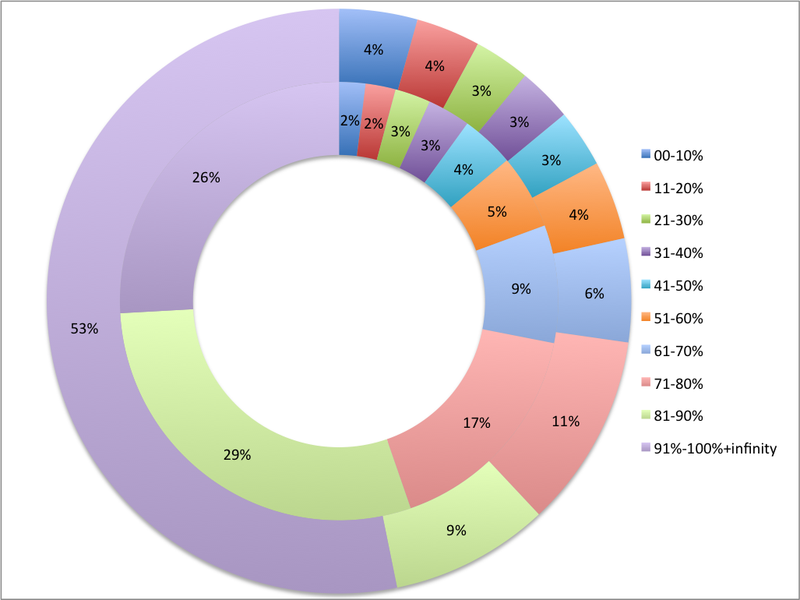

NFS上のWrite Backの仮想マシンのレイテンシの改善 ー Read(内側)とWrite(外側)

Satyam : さぁ、準備はいいかい? いっぱいあるけど、以下の様なところが見どころさ、それ以外は読者の楽しみとして取っておきます。

- VMFS上の仮想マシンでWrite Throughに設定されている場合、35%もの場合で、100%以上のレイテンシの改善が見られています。つまり、SANのレイテンシよりも仮想マシンから見たレイテンシが半分以下になっているということです。

- Write Throughに設定されている仮想マシンでも、ストレージに対する負荷が下がることで実際にはWriteのパフォーマンスを向上させることができています。14%ものWrite Throughの仮想マシンが80%~90%の割合でWriteのレイテンシの改善をしています。これはとーーーーっても大きい!!

- NFSのチャートの右上、NFSの仮想マシンはより大きなレイテンシの改善がなされています。これはNFSはダメだからです(パフォーマンスの観点からはね・・・。)

- Write Backに目を移しましょう。VMFSで動作している仮想マシンの半分はWriteBackで100%以上のレイテンシを改善しています。Write Backはすごいね!

- 一般的にはほとんどの仮想マシンが50%以上のレイテンシの改善しています。Readでも、Writeでも、Write ThroughでもWrite Backでも、VMFSでもNFSでも。なんという強者っぷり!

実際のデータは見ていただいたとおりです、注目したいのはWrite ThroughでのSANのWriteレイテンシの改善です。これは実際の話しですし、オールフラッシュストレージの上でFVPでRAMによる高速化(DFTM)を実施したことを考えてみてください。最近、Ramboll社 ーグローバルで展開するエンジニアリング会社ー が何故Pureのオールフラッシュストレージの上で、DFTMを利用するFVPを導入したのかという理由を答えてくれています。レコーディングは以下から聞くことが出来ます。Maximize Your All Flash Array Investment With Analytics(訳注:英語ビデオ)

Chethan Kumar氏、我々のパフォーマンスエンジニアもSANのレイテンシがFVPを動作させる前よりも下がったということを述べています。帯域が削減されることにより、ストレージエリアネットワークとストレージコントローラーに対する負荷が下がるからです。もし90,000もの仮想マシンからのIOが発行されたとすると、レイテンシはもっと高いものになっているはずです。そうした意味では、このドーナツチャートで見るよりも実際の結果はもっと優れたものになるはずです。本当のドーナツでは殆どが紫になってしまい、上の方にちょこっと色が出てくるような状態のはずです。

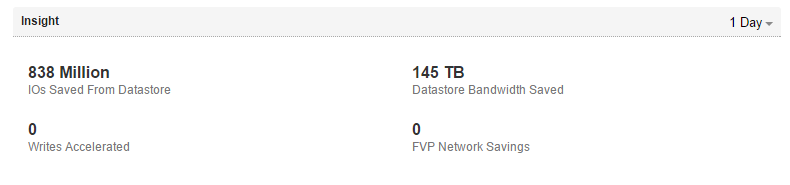

Write Throughで削減される仮想マシンからの帯域の総量を甘く見てはいけません。今週私は32のデータベースを動作させている仮想マシンを高速化されているお客様をご訪問いたしましたが、1日辺りで145TBもの帯域が削減されていました。ストレージエリアネットワークでの帯域はストレージ装置自身のキャッシュにも影響をあたえるのです。

我々がFVPによるメリットにどれだけの確信を持っているかを示すために、我々は「Fastest SAN alive(最速のSANの誕生)」キャンペーンを実施しています。最大で10倍の高速な仮想マシンのパフォーマンスをFVPが実現するということを是非チャレンジしてみてください。詳細はこちらです。

訳注 : 残念ながら上記のキャンペーンは国内では展開されておりませんが、FVPのパフォーマンス改善とその効果に絶対の自信があるということは上記の統計からの実際のお客様の例からも明らかです。是非無料トライアルをお試しください!

記事担当者: マーケティング本部 三好哲生 (@pernixdata_netw)